Tecnología

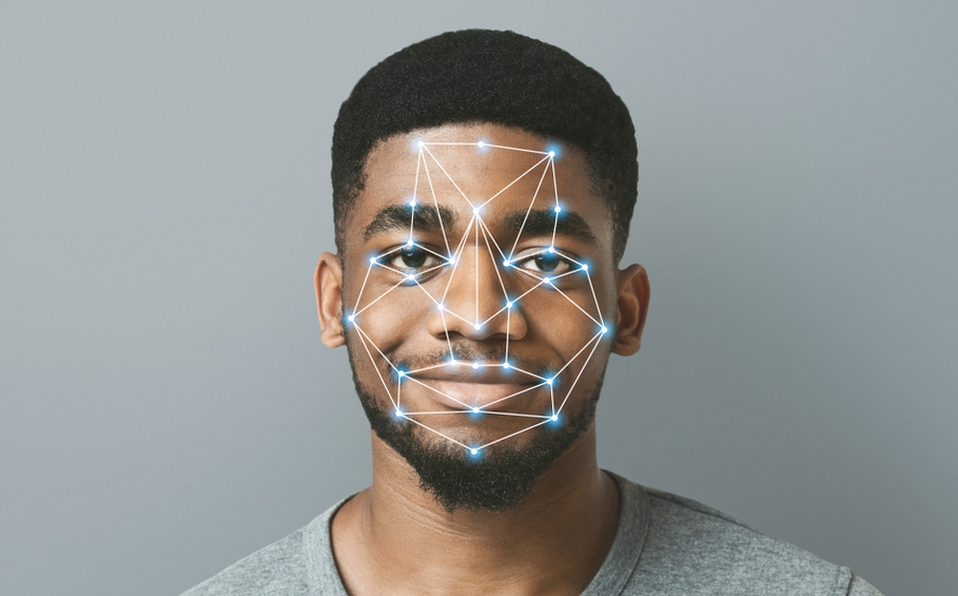

¿Reconocimiento facial racista? Hay más fallas con afroamericanos y asiáticos

Publicado

hace 4 añosPor

SICOM Noticias

Un estudio demostró que los algoritmos fallan de 10 a 100 veces más al reconocer caras de afroamericanos y asiáticos.

Un estudio del Instituto Nacional de Estándares y Tecnología (NIDT, según sus siglas en inglés) de Estados Unidos confirmaron que la mayoría de los algoritmos de reconocimiento facial muestran sesgos raciales, ya que tienen problemas a la hora de identificar a personas no caucásicas.

Los algoritmos identificaron erróneamente de 10 a 100 veces más las caras de afroamericanos y asiáticos que las de caucásicos, según el informe.

Además, el estudio subrayó que en una base de datos de fotografías utilizada por las autoridades estadounidenses, las tasas de error más altas se produjeron a la hora de identificar a nativos americanos.

“Descubrimos que los falsos positivos son más altos en las mujeres que en los hombres y esto es consistente en todos los algoritmos y conjuntos de datos”, así como en los ancianos y niños, detalla el estudio, que subraya que en las imágenes de fichas policiales “los falsos positivos más altos se encuentran en los nativos americanos, con tasas elevadas en la población afroamericana y asiática”.

El investigador principal del estudio, Patrick Grother, recalcó que un falso negativo puede ser un gran inconveniente, ya que los usuarios, por ejemplo, no podrían acceder a su teléfono.

Según el estudio, las mujeres afroamericanas son más propensas que otros grupos a ser identificadas erróneamente en una base de datos con fotografías policiales del FBI.

Los investigadores afirman que los falsos positivos son muy importantes porque “las consecuencias podrían incluir detenciones y acusaciones por error”.

Fuente: milenio.com.mx

Te puede interesar

-

Consigue FGE vincular a proceso a Marcos N., por por usurpación de funciones

-

Reconoce Ayuntamiento de Puebla a cuatro policías municipales por detener a asaltantes

-

Por quinto año consecutivo, SMDIF recibe reconocimiento nacional por la calidad de su laboratorio

-

“A diferencia del final de otras administraciones, veremos momento estelar de la 4T”: Luisa María Alcalde ante diplomáticos

-

Garantizado abasto de maíz blanco en Puebla: Secretaría de Desarrollo Rural

-

Explorando el cielo durante diciembre de 2023: Solsticio, lluvias de meteoros y más

Anuncia José Mujica, expresidente de Uruguay, que padece cáncer de esófago

A disposición del juez extorsionadores de Hidalgo y CDMX